九天菜菜深度学习实战

├──深度学习网盘

| ├──001.Lesson 0.1 GPU购买与GPU白嫖指南.mp4 142.26M

| ├──002.Lesson 0.2 PyTorch安装与部署(CPU版本).mp4 85.71M

| ├──003.Lesson 0.3 PyTorch安装与配置(GPU版本).mp4 133.96M

| ├──004.Lesson 1 张量的创建与常用方法.mp4 404.65M

| ├──005.Lesson 2 张量的索引、分片、合并及维度调整.mp4 305.24M

| ├──006.Lesson 3 张量的广播和科学运算.mp4 312.28M

| ├──007.Lesson 4 张量的线性代数运算.mp4 407.08M

| ├──008.Lesson 5 基本优化方法与最小二乘法.mp4 1.51G

| ├──009.Lesson 6 动态计算图与梯度下降入门.mp4 1.46G

| ├──010.Lesson 7.1 神经网络的诞生与发展_batch.mp4 217.83M

| ├──011.Lesson 7.2 机器学习中的基本概念.mp4 509.35M

| ├──012.Lesson 7.3 深入理解PyTorch框架.mp4 411.52M

| ├──013.Lesson 8.1单层回归神经网络 & Tensor新手避坑指南.mp4 799.78M

| ├──014.Lesson 8.2 torch.nn.Linear实现单层回归网络的正向传播.mp4 318.35M

| ├──015.Lesson 8.3 二分类神经网络的原理与实现.mp4 498.14M

| ├──016.Lesson 8.4 torch.nn.functional实现单层二分类网络的正向传播.mp4 216.03M

| ├──017.Lesson 8.5 多分类神经网络.mp4 531.86M

| ├──018.Lesson 9.1 从异或门问题认识多层神经网络.mp4 732.25M

| ├──019.Lesson 9.2 黑箱:深度神经网络的不可解释性.mp4 405.00M

| ├──020.Lesson 9.3 & 9.4 层与激活函数.mp4 262.03M

| ├──021.Lesson 9.5 从0实现深度神经网络的正向传播.mp4 997.90M

| ├──022.Lesson 10.1 SSE与二分类交叉熵损失.mp4 222.57M

| ├──023.Lesson 10.2 二分类交叉熵的原理与实现.mp4 408.43M

| ├──024.Lesson 10.3 多分类交叉熵的原理与实现.mp4 487.38M

| ├──025.Lesson 11.1 梯度下降中的两个关键问题.mp4 525.79M

| ├──026.Lesson 11.2.1 反向传播的原理.mp4 505.30M

| ├──027.Lesson 11.2.2 反向传播的实现.mp4 417.51M

| ├──028.Lesson 11.3 走出第一步:动量法Momentum.mp4 655.70M

| ├──029.Lesson 11.4 开始迭代:batch与epochs.mp4 674.39M

| ├──030.Lesson 11.5.1 在Fashion-MNIST数据集上实现完整的神经网络(上).mp4 504.54M

| ├──031.Lesson 11.5.2 在Fashion-MNIST数据集上实现完整的神经网络(下).mp4 1017.73M

| ├──032.Lesson 12.0 深度学习基础网络手动搭建与快速实现.mp4 236.24M

| ├──033.Lesson 12.1 深度学习建模实验中数据集生成函数的创建与使用.mp4 1.19G

| ├──034.Lesson 12.2 可视化工具TensorBoard的安装与使用.mp4 387.52M

| ├──035.Lesson 12.3 线性回归建模实验.mp4 569.75M

| ├──036.Lesson 12.4 逻辑回归建模实验.mp4 704.44M

| ├──037.Lesson 12.5 softmax回归建模实验.mp4 959.72M

| ├──038.Lesson 13.1 深度学习建模目标与性能评估理论.mp4 1.10G

| ├──039.Lesson 13.2.1 模型拟合度概念介绍与欠拟合模型的结构调整策略.mp4 1.20G

| ├──040.Lesson 13.2.2 【加餐】损失函数的随机创建现象详解.mp4 357.39M

| ├──041.Lesson 13.3.1 梯度不平稳性与Glorot条件(1).mp4 624.94M

| ├──042.Lesson 13.3.2 梯度不平稳性与Glorot条件(2).mp4 457.15M

| ├──043.Lesson 13.3.3 梯度不平稳性与Glorot条件(3).mp4 514.04M

| ├──044.Lesson 13.4 Dead ReLU Problem与学习率优化.mp4 763.22M

| ├──045.Lesson 13.5 Xavier方法与kaiming方法(HE初始化).mp4 919.39M

| ├──046.Lesson 14.1 数据归一化与Batch Normalization基础理论.mp4 1.01G

| ├──047.Lesson 14.2 Batch Normalization在PyTorch中的实现.mp4 1.16G

| ├──048.Lesson 14.3 Batch Normalization综合调参实战.mp4 944.67M

| ├──049.Lesson 15.1 学习率调度基本概念与手动实现方法.mp4 895.10M

| ├──050.Lesson 15.2 学习率调度在PyTorch中的实现方法.mp4 885.37M

| ├──051.Lesson 16.1 配置环境,计算机视觉行业综述.mp4 216.47M

| ├──052.Lesson 16.2 图像的基本操作.mp4 579.20M

| ├──053.Lesson 16.3 卷积操作与边缘检测.mp4 431.99M

| ├──054.Lesson 16.4 卷积遇见深度学习.mp4 291.32M

| ├──055.Lesson 16.5.1 在Pytorch中实现卷积网络:卷积核、输入通与特征图.mp4 444.89M

| ├──056.Lesson 16.5.2 在PyTorch中实现卷积网络:步长与填充.mp4 621.77M

| ├──057.Lesson 16.5.3 在PyTorch中实现卷积网络:池化层,BN与Dropout.mp4 467.97M

| ├──058.Lesson 16.6.1 复现经典架构(1):LeNet5.mp4 374.24M

| ├──059.Lesson 16.6.2 复现经典架构(2):AlexNet.mp4 770.77M

| ├──060.Lesson 16.7 如何拓展网络深度:VGG架构.mp4 213.36M

| ├──061.Lesson 16.8.1 感受野(上):定义与性质.mp4 616.97M

| ├──062.Lesson 16.8.2 感受野(下):膨胀卷积,计算感受野大小.mp4 675.63M

| ├──063.Lesson 16.9 平移不变性.mp4 528.63M

| ├──064.Lesson 16.10 卷积层的参数量计算,1×1卷积核.mp4 402.89M

| ├──065.Lesson 16.11 分组卷积与深度可分离卷积.mp4 392.89M

| ├──066.Lesson 16.12 全连接层的参数,用nn.Sequential复现VGG16.mp4 648.87M

| ├──067.Lesson 16.13 全局平均池化,NiN网络的复现.mp4 545.96M

| ├──068.Lesson 16.14 GoogLeNet:思想与具体架构.mp4 739.65M

| ├──069.Lesson 16.15 GoogLeNet的复现.mp4 1008.56M

| ├──070.Lesson 16.16 残差网络:思想与具体架构.mp4 553.92M

| ├──071.Lesson 16.17.1 ResNet的复现 (1) :架构中的陷阱.mp4 461.80M

| ├──072.Lesson 16.17.2 ResNet的复现 (2) :卷积块、残差块、瓶颈架构.mp4 1.00G

| ├──073.Lesson 16.17.3 ResNet的复现 (3):完整的残差网络.mp4 1.08G

| ├──074.Lesson 17.1 计算机视觉中的三种基本任务.mp4 401.44M

| ├──075.Lesson 17.2.1 经典数据集(1):入门数据集,新手读数据踩坑指南.mp4 511.58M

| ├──076.Lesson 17.2.2 经典数据集(2):竞赛数据与其他常用数据.mp4 510.58M

| ├──077.Lesson 17.3.1 使用自己的图像创造数据集.mp4 987.00M

| ├──078.Lesson 17.3.2 将二维表及其他结构转化为四维tensor.mp4 596.80M

| ├──079.Lesson 17.4 图像数据的数据预处理.mp4 385.51M

| ├──080.Lesson 17.5 数据增强.mp4 447.23M

| ├──081.【直播加餐】01 LSTM的原理与基本架构_v.mp4 223.80M

| ├──082.【直播加餐】02 深度原理:LSTM是如何解决梯度问题的?.mp4 161.02M

| ├──083.【直播加餐】03 PyTorch中的LSTM参数简介_v.mp4 132.39M

| ├──084.【直播加餐】04 LSTM在股价数据集上的预测实战_v.mp4 218.23M

| ├──085.【直播加餐】05 时间序列卷积的运算流程与操作v.mp4 175.69M

| ├──086.【直播加餐】06 时序卷积网络TCN架构解析与复现 v.mp4 181.72M

| ├──087.【直播加餐】07 Transformer中的注意力机制_v.mp4 227.85M

| ├──088.【直播加餐】08 Transformer中的Embedding与位置编码v.mp4 69.87M

| ├──089.【直播加餐】09 Transformer在Pytorch中的参数与实现v.mp4 191.73M

| ├──090.【直播加餐】10 Huggingface入门:bert gpt调用_v.mp4 176.93M

| ├──091.Lesson 17.6.1 更强大的优化算法 (1) AdaGrad.mp4 603.25M

| ├──092.Lesson 17.6.2 更强大的优化算法(2) RMSprop与Adam.mp4 638.83M

| ├──093.Lesson 17.7 调用经典架构.mp4 244.63M

| ├──094.Lesson 17.8.1 基于ResNet与VGG16自建架构.mp4 391.32M

| ├──095.Lesson 17.8.2 基于普通卷积层和池化层自建架构.mp4 285.16M

| ├──096.Lesson 17.9 有监督算法的预训练_迁移学习.mp4 688.17M

| ├──097.Lesson 17.10 深度学习中的模型选择.mp4 430.00M

| ├──098.Lesson 17.11(1) 案例1:项目背景_完整流程概述.mp4 350.17M

| ├──099.Lesson 17.11(2) 案例1:数据与架构.mp4 668.51M

| ├──100.Lesson 17.11(3) 案例1:提前停止.mp4 423.70M

| ├──101.Lesson 17.11(4) 案例1:一个完整的训练函数.mp4 891.11M

| ├──102.Lesson 17.11(5) 准备训练函数所需的全部参数.mp4 166.22M

| ├──103.Lesson 17.11(6) GPU内存管理机制、训练函数的GPU版本.mp4 309.19M

| ├──104.Lesson 17.11(7) 初步训练:模型选择.mp4 256.70M

| ├──105.Lesson 17.11(8) 模型调优(1):增加迭代次数,让迭代更稳定.mp4 284.81M

| ├──106.Lesson 17.11(9) 模型调优(2):对抗过拟合,其他可探索的方向.mp4 255.09M

| ├──107.Lesson 18.1 生成对抗网络的基本原理与损失函数.mp4 292.32M

| ├──108.Lesson 18.2.1 (1) 从0实现GAN的反向传播与训练.mp4 271.91M

| ├──109.Lesson 18.2.2 (2) 判别器的反向传播.mp4 201.91M

| ├──110.Lesson 18.2.3 (3) 生成器的反向传播.mp4 318.70M

| ├──111.Lesson 18.3.1 转置卷积层与DCGAN(1):基本原理与实现.mp4 278.43M

| ├──112.Lesson 18.3.2 转置卷积层与DCGAN(2):带步长与填充的转置卷积层(上.mp4 137.07M

| ├──113.Lesson 18.3.2 转置卷积层与DCGAN(2):带步长与填充的转置卷积层(下.mp4 174.28M

| ├──114.Lesson 18.3.2 转置卷积层与DCGAN(3):DCGAN架构复现 (上).mp4 176.00M

| ├──115.Lesson 18.3.2 转置卷积层与DCGAN(3):DCGAN架构复现 (下).mp4 143.23M

| ├──116.Lesson 18.3.2 转置卷积层与DCGAN(4):从DCGAN到pix2pix.mp4 66.02M

| ├──117.Lesson 18.3.3 cGAN与InfoGAN(1):基本运行原理.mp4 222.81M

| ├──118.Lesson 18.3.3 cGAN与InfoGAN(2) 标签输入与Embed技巧.mp4 314.87M

| ├──119.Lesson 18.3.3 cGAN与infoGAN (3) 从0复现一个cGAN架构.mp4 232.40M

| ├──120.Lesson 18.4.1 自动编码器家族(1):认识自动编码器.mp4 152.73M

| ├──121.Lesson 18.4.1 自动编码器家族(2):三大类自动编码器.mp4 249.38M

| ├──122.Lesson 18.4.1 自动编码器家族(3):自动编码器的应用场景.mp4 172.86M

| ├──123.Lesson 18.4.2 变分自动编码器(1):数据流与细节梳理.mp4 233.80M

| ├──124.Lesson 18.4.2 变分自动编码器(2):损失函数详解.mp4 186.66M

| ├──125.Lesson 18.4.2 变分自动编码器(3):重参数化技巧.mp4 115.78M

| ├──126.Lesson 18.5.1 分割架构必备基础.mp4 182.77M

| ├──127.Lesson 18.5.2 Unet架构复现.mp4 195.50M

| ├──128.Lesson 19.1.1 欢迎来到NLP的世界.mp4 150.91M

| ├──129.Lesson 19.1.2 大模型的行业影响与发展.mp4 178.69M

| ├──130.Lesson 19.2.1 深度学习中的时间序列数据.mp4 119.20M

| ├──131.Lesson 19.2.2 文字序列数据 – 结构与分词操作.mp4 131.31M

| ├──132.Lesson 19.2.3 文字序列数据 – Token与编码.mp4 146.54M

| ├──133.Lesson 19.3.1~3.2 RNN的架构与数据流.mp4 176.46M

| ├──134.Lesson 19.3.3 各类NLP任务下循环神经网络的输入与输出.mp4 237.22M

| ├──135.Lesson 19.3.4.1 认识PyTorch中nn.RNN层.mp4 119.92M

| ├──136.Lesson 19.3.4.2 在PyTorch中实现RNN.mp4 141.82M

| ├──137.Lesson 19.3.4.3 深度神经网络的实现.mp4 158.17M

| ├──138.Lesson 19.3.4.4 自定义循环层中的循环数据流.mp4 86.76M

| ├──139.Lesson 19.3.4.5 双向循环神经网络.mp4 64.68M

| ├──140.Lesson 19.3.4.6【加餐】手动实现RNN执行情感分类任务.mp4 82.27M

| ├──141.Lesson 19.3.4.7【加餐】手动实现RNN执行文本生成任务.mp4 61.06M

| ├──142.Lesson 19.3.5.1 RNN反向传播的数学流程.mp4 155.82M

| ├──143.Lesson 19.3.5.2 RNN各类缺陷的数学本质.mp4 133.64M

| ├──144.Lesson 20.1.0 LSTM开篇与学习路径.mp4 64.22M

| ├──145.Lesson 20.1.1.1 LSTM的起源:权重冲突.mp4 113.14M

| ├──146.Lesson 20.1.1.2 LSTM治理权重冲突问题的基本思路.mp4 107.63M

| ├──147.Lesson 20.1.2.1 LSTM的架构:信息分割与门控单元.mp4 163.15M

| ├──148.Lesson 20.1.2.2 LSTM的架构:解决权重冲突与输出门.mp4 93.21M

| ├──149.Lesson 20.1.2.3 LSTM中的浅层数学讨论.mp4 94.77M

| ├──150.Lesson 20.1.3.1 nn.LSTM层的参数群 (上).mp4 161.76M

| ├──151.Lesson 20.1.3.1 nn.LSTM层的参数群 (下):Proj_size.mp4 136.84M

| ├──152.Lesson 20.1.3.2 nn.LSTM层的输入与输出.mp4 126.49M

| ├──153.Lesson 20.1.3.3 在PyTorch中实现完整LSTM网络.mp4 162.19M

| ├──154.Lesson 20.1.4.1 LSTM在单变量数据集上的预测实战(上).mp4 131.18M

| ├──155.Lesson 20.1.4.1 LSTM在单变量数据集上的预测实战(下).mp4 140.13M

| ├──156.Lesson 24.1.1 谷歌邮箱Gmail注册.mp4 107.26M

| ├──157.Lesson 24.1.2 OpenAI账号注册.mp4 36.94M

| ├──158.Lesson 24.1.3 ChatGPT Plus升级流程.mp4 88.12M

| ├──159.Lesson 24.1.4 ChatGPT防封指南.mp4 55.72M

| ├──160.Lesson 24.2.1 大模型技术学习目标和内容规划.mp4 98.68M

| ├──161.Lesson 24.2.2 OpenAI在线大模型生态介绍.mp4 149.52M

| ├──162.Lesson 24.2.3 开源大模型生态与ChatGLM-6B大模型介绍.mp4 207.13M

| ├──163.Lesson 24.3.1 大语言模型的基本深度学习概念补充讲解.mp4 224.75M

| ├──164.Lesson 24.3.2 OpenAI Fine-tuning API简介.mp4 41.79M

| ├──165.Lesson 24.3.3 开源微调框架入门介绍.mp4 209.36M

| ├──166.Lesson 24.4 大模型课程硬件要求说明.mp4 156.22M

| ├──167.Lesson 24.5 LangChain入门介绍.mp4 146.39M

| ├──168.Lesson 24.6.1 OpenAI官网使用说明.mp4 178.11M

| ├──169.Lesson 24.6.2 本地调用OpenAI API方法.mp4 89.23M

| ├──170.Lesson 24.7.1 Completion模型与Chat模型介绍.mp4 104.34M

| ├──171.Lesson 24.7.2 Completion.create函数参数详解.mp4 180.87M

| ├──172.Lesson 24.7.3 Completion.create函数调参数实践.mp4 104.56M

| ├──173.Lesson 24.7.4 手动创建可调节对话风格的对话机器人.mp4 84.52M

| ├──174.Lesson 24.8.1 大语言模型原生能力与涌现能力介绍.mp4 70.58M

| ├──175.Lesson 24.8.2 提示工程技术入门.mp4 108.16M

| ├──176.Lesson 24.9.1 One-shot&Few-shot提示方法.mp4 111.58M

| ├──177.Lesson 24.9.2 Zero-shot-CoT提示法.mp4 126.45M

| ├──178.Lesson 24.9.3 Few-shot-CoT提示法.mp4 72.67M

| ├──179.Lesson 24.9.4 LtM提示方法.mp4 107.64M

| ├──180.Lesson 24.10.1 SCAN指令翻译项目介绍与数据集准备.mp4 157.56M

| ├──181.Lesson 24.10.2 针对SCAN数据集的Few-shot-LtM提示工程流程.mp4 306.65M

| ├──182.Lesson 24.10.3 SCAN指令翻译项目完整建模流程.mp4 134.96M

| ├──183.Lesson 24.11.1 Chat Completion模型背景介绍.mp4 124.38M

| ├──184.Lesson 24.11.2 Chat Completion模型发展现状.mp4 99.51M

| ├──185.Lesson 24.12.1 Chat Completion模型API详解.mp4 249.73M

| ├──186.Lesson 24.12.2 Messages参数设置技巧.mp4 167.01M

| └──187.Lesson 24.12.3 基于特定知识的简易问答机器人创建方法.mp4 147.30M

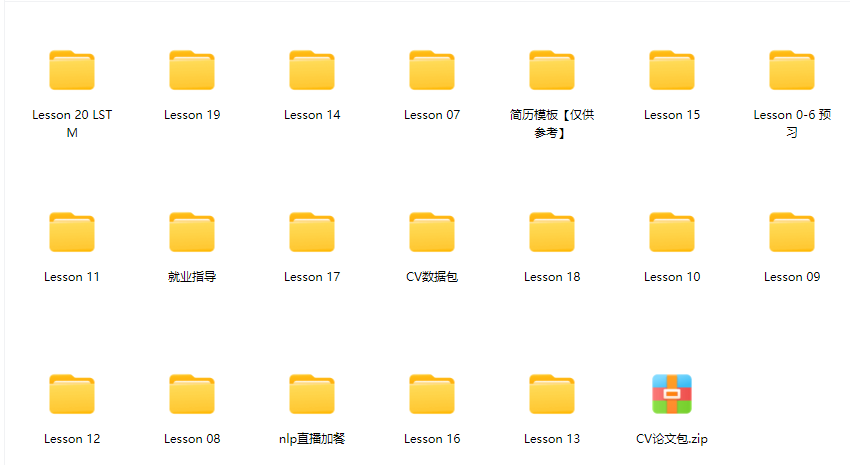

└──深度学习训练营课件

| ├──CV数据包

| | ├──datasets

| | ├──datasets2

| | ├──datasets3

| | ├──datasets4.zip 183.85M

| | └──必须下载datasets4和datasets2中的LSUN,其他按需下载.txt

| ├──Lesson 0-6 预习

| | ├──【PDF配套代码】code

| | ├──0 GPU选择指南 + PyTorch安装及环境搭建 V4.pdf 4.84M

| | ├──0 Python的安装与环境配置.pdf 7.16M

| | ├──Lesson 1.张量(Tensor)的创建和索引.pdf 8.89M

| | ├──Lesson 2.张量的索引、分片、合并以及维度调整.pdf 7.22M

| | ├──Lesson 3.张量的广播和科学运算.pdf 12.66M

| | ├──Lesson 4.张量的线性代数运算.pdf 13.11M

| | ├──Lesson 5.基本优化思想与最小二乘法.pdf 12.60M

| | └──Lesson 6.动态计算图与梯度下降入门.pdf 17.13M

| ├──Lesson 07

| | └──Lesson 7 认识深度学习,认识PyTorch.pdf 7.59M

| ├──Lesson 08

| | ├──Lesson 8 单层神经网络.pdf 2.04M

| | └──【PDF配套代码】Lesson 8.ipynb 33.26kb

| ├──Lesson 09

| | ├──Lesson 9 深层神经网络.pdf 1.79M

| | └──【PDF配套代码】Lesson 9.ipynb 99.90kb

| ├──Lesson 10

| | ├──Lesson 10 神经网络的损失函数.pdf 1.10M

| | └──【PDF配套代码】Lesson 10.ipynb 10.69kb

| ├──Lesson 11

| | ├──creditcard.csv 143.84M

| | ├──Lesson 11 神经网络的学习.pdf 3.02M

| | ├──MINST-FASHION数据集.zip 150.47M

| | └──【PDF配套代码】Lesson 11.ipynb 261.25kb

| ├──Lesson 12

| | ├──【PDF配套代码】code

| | ├──Lesson 12.0 深度学习基础网络手动搭建与快速实现.pdf 3.13M

| | ├──Lesson 12.1 深度学习建模实验中数据集创建函数的创建与使用.pdf 9.81M

| | ├──Lesson 12.2 PyTorch深度学习建模可视化工具TensorBoard的安装与使用.pdf 5.14M

| | ├──Lesson 12.3 线性回归建模实验.pdf 5.96M

| | ├──Lesson 12.4 逻辑回归建模实验.pdf 9.88M

| | ├──Lesson 12.5 softmax回归建模实验.pdf 18.34M

| | └──torchLearning.py 53.84kb

| ├──Lesson 13

| | ├──【PDF配套代码】code

| | ├──Lesson 13.1 深度学习建模目标与性能评估理论.pdf 26.62M

| | ├──Lesson 13.2 模型拟合度概念介绍与欠拟合模型的结构调整策略.pdf 24.67M

| | ├──Lesson 13.2【加餐】 损失函数的随机创建现象详解.pdf 3.67M

| | ├──Lesson 13.3 梯度不平稳性与Glorot条件.pdf 31.39M

| | ├──Lesson 13.4 Dead ReLU Problem与学习率优化.pdf 13.11M

| | └──Lesson 13.5 Xavier方法与kaiming方法(HE初始化).pdf 22.87M

| ├──Lesson 14

| | ├──【PDF配套代码】code

| | ├──Lesson 14.1 数据归一化与Batch Normalization理论基础.pdf 22.06M

| | ├──Lesson 14.2 Batch Normalization在PyTorch中的实现.pdf 26.31M

| | └──Lesson 14.3 Batch Normalization综合调参实战.pdf 19.64M

| ├──Lesson 15

| | ├──【PDF配套代码】code

| | ├──Lesson 15.1 学习率调度基本概念与手动实现方法.pdf 9.27M

| | └──Lesson 15.2 学习率调度在PyTorch中的实现方法.pdf 18.51M

| ├──Lesson 16

| | ├──torch_receptive_field

| | ├──图像

| | ├──Lesson 16 计算机视觉开篇(上).pdf 8.27M

| | ├──Lesson 16 计算机视觉开篇(下).pdf 13.92M

| | ├──Lesson 16.14 – END.ipynb 68.45kb

| | ├──Lesson 16.1~16.6.ipynb 5.56M

| | ├──Lesson 16.7~16.13.ipynb 30.02kb

| | └──torchLearning.py 56.33kb

| ├──Lesson 17

| | ├──Lesson 17 深度视觉进阶.pdf 19.40M

| | ├──【PDF配套代码】Lesson 17.1 – 17.3.ipynb 947.04kb

| | ├──【PDF配套代码】Lesson 17.11 Case 1 – SVHN.ipynb 138.33kb

| | ├──【PDF配套代码】Lesson 17.4 & 17.5.ipynb 265.74kb

| | └──【PDF配套代码】Lesson 17.6 – 17.10.ipynb 100.12kb

| ├──Lesson 18

| | ├──data

| | ├──datalist.zip 4.35M

| | ├──Lesson 18 Kaggle医学影象识别 C4.5.ipynb 80.16kb

| | ├──Lesson 18 Kaggle医学影像识别 C1~C4.3.ipynb 26.52M

| | ├──Lesson 18 Kaggle医学影像识别 C4.4.ipynb 711.61kb

| | ├──MNIST.zip 22.05M

| | └──分割必备基础&Unet架构复现.ipynb 61.22kb

| ├──Lesson 19

| | ├──加餐所用数据集&代码

| | ├──Lesson 19 RNN v0807.html 771.41kb

| | └──Lesson 19 RNN v0807.ipynb 134.99kb

| ├──Lesson 20 LSTM

| | ├──airline-passengers.csv 2.13kb

| | ├──lesson 20 LSTM与GRU(上).ipynb 92.16kb

| | ├──lesson 20 LSTM与GRU(下)v2月6日.ipynb 492.01kb

| | ├──stock_list.csv 753.81kb

| | └──stock_prices.csv 207.52M

| ├──nlp直播加餐

| | ├──bert-base-chinese.zip 1.48G

| | ├──bert-base-multilingual-cased.zip 2.79G

| | ├──Day 4 Transformer原理精讲.ipynb 44.12kb

| | ├──Day1 LSTM与深度学习中的时间序列.ipynb 36.98kb

| | ├──Day2 LSTM的参数全解与股价预测实战.ipynb 184.39kb

| | ├──Day3.5 加餐:LSTM原理与数学精讲.ipynb 44.33kb

| | ├──Day5 transformer的Pytorch与Huggingface实践.ipynb 177.92kb

| | ├──gpt2.zip 4.70G

| | └──single_stock.csv 27.10kb

| ├──简历模板【仅供参考】

| | ├──数据分析简历模板.zip 6.62M

| | └──算法简历模板.zip 5.59M

| ├──就业指导

| | ├──打造黄金简历,解锁面试技巧.pdf 1.44M

| | └──直播回放地址.txt 0.22kb

| └──CV论文包.zip 65.69M

评论1